Принцип работы метода k-ближайших соседей (k-NN)

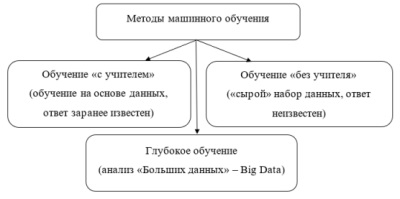

Метод k-ближайших соседей (k-NN) является одним из наиболее простых и широко используемых алгоритмов машинного обучения. Он используется для решения задач классификации и регрессии. Принцип работы метода k-NN заключается в том, что объект классифицируется на основе близости к ближайшим к нему объектам обучающей выборки. Количество ближайших соседей (k) выбирается заранее.

Для классификации нового объекта метод k-NN проходит следующие шаги:

- Вычисление расстояния между новым объектом и всеми объектами обучающей выборки.

- Выбор k ближайших объектов обучающей выборки.

- Определение класса нового объекта на основе классов k ближайших объектов.

Для регрессии метод k-NN также использует ближайших соседей, но вместо классов объектов используются их числовые значения. Например, если необходимо предсказать цену на недвижимость, то для каждого нового объекта вычисляется расстояние до k ближайших объектов обучающей выборки, и как результат, предсказывается среднее или медианное значение цены на недвижимость среди k ближайших объектов.

Метод k-NN не требует предварительной обработки данных и может использоваться для любых типов данных. Он является достаточно точным и устойчивым алгоритмом, который может работать с большим количеством данных. Однако, его производительность может снижаться с увеличением размерности данных, и выбор оптимального значения k может быть нетривиальной задачей.

Выбор оптимального значения k

Одним из главных вопросов при использовании метода k-NN является выбор оптимального значения k. Выбор k может существенно влиять на качество классификации или регрессии. Если k выбрано слишком маленьким, то классификация или регрессия может оказаться неустойчивой к шуму в данных. Если k выбрано слишком большим, то алгоритм может упроститься до большинства голосов в выборке, и результат будет неинформативным.

Существует несколько методов для выбора оптимального значения k:

- Перекрестная проверка (cross-validation) . Этот метод заключается в разбиении обучающей выборки на несколько частей, обучении модели на одной части и проверке на оставшихся. Таким образом, можно оценить качество модели при разных значениях k.

- Анализ ошибок на обучающей выборке (training error analysis) . Этот метод заключается в вычислении ошибок классификации или регрессии на обучающей выборке при разных значениях k. Оптимальное значение k будет соответствовать минимальной ошибке.

- Анализ ошибок на тестовой выборке (test error analysis) . Этот метод заключается в вычислении ошибок классификации или регрессии на тестовой выборке при разных значениях k. Оптимальное значение k будет соответствовать минимальной ошибке.

Выбор оптимального значения k может быть нетривиальной задачей, особенно при работе с большими наборами данных. Однако, правильный выбор k может существенно повлиять на качество классификации или регрессии, поэтому этот вопрос требует тщательного анализа и подхода к решению.

Преимущества и недостатки метода k-NN

Метод k-NN имеет свои преимущества и недостатки, которые необходимо учитывать при его использовании в задачах классификации или регрессии.

Среди преимуществ метода k-NN можно выделить следующие:

- Простота и легкость в реализации.

- Может быть использован для задач классификации и регрессии.

- Не требует предположений о распределении данных.

- Может быть использован с любыми типами данных (непрерывные, дискретные, бинарные) .

- Хорошо работает в задачах с малым числом признаков или признаков низкой размерности.

Однако, у метода k-NN также есть недостатки:

- Низкая скорость работы при большом объеме данных и/или большом числе признаков.

- Требует большого объема памяти для хранения обучающей выборки.

- Неэффективен в задачах с большим числом классов.

- Чувствителен к шуму в данных.

- Не работает хорошо с данными, содержащими много выбросов или пропущенных значений.

При выборе метода k-NN для решения конкретной задачи необходимо учитывать как его преимущества, так и недостатки, и оптимально подбирать параметры алгоритма в зависимости от особенностей данных и требуемой точности результата.